具身智能迎来实力派!十年多模态打底,世界模型开路,商汤「悟能」来了

- 数码攻略

- 2025-07-31

- 6

- 更新:2025-07-31 19:11:01

WAIC 2025 大模型论坛上,商汤科技正式发布了「悟能」具身智能平台,官宣入局具身智能。

以此为出发点,商汤科技在具身智能领域的布局也开始浮出水面。

站在这个具身智能的风口之上,商汤选择此时入局,体现了怎样的思考,其背后又有着怎样的积淀?

吸引 AI 头部企业、初创公司和投资者们纷纷踏足,具身智能又究竟发展到了哪一步?

在这场论坛上,这些问题的答案被一一揭开。

新型多模态模型亮相 WAIC

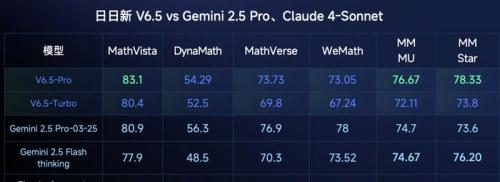

先来看商汤发布的日日新 V6.5 多模态推理大模型。

日日新 6.5 独创了图文交错思维链,跨模态推理精度显著提升。

传统的多模态推理模型,在推理之前会将图像转变成文本解读,后续的推理过程就变成了纯文本。

而在图文交错思维链当中,图像会以本体的形式参与到整个推理过程。

在这种图文混合的思考模式下,日日新 6.5 的多媒体推理能力在多个数据集上都超越了 Gemini 2.5 Pro。

同时依托轻量 Vision Encoder +和纵深 LLM 架构,日日新 6.5 相比 6.0 表现提升了 6.99%,但推理成本只有日日新 6.0 的 30%,综合算下来性价比提升了 5 倍。

随着模型能力提升,商汤在大模型落地上,就不止做「卖软件」的生意,还做「卖大脑」的生意。

从多模态模型到具身智能大脑

其实,商汤能够高调切入具身智能,是其从感知视觉、多模态,走向物理世界交互的必然结果。

商汤科技联合创始人、执行董事、首席科学家林达华认为,多模态是迈向 AGI 的必经之路。因此,只有能够同时「读文本、看世界、动手脚」,AI 才可能真正理解并改造物理环境。

而且超过十年的行业落地经验,包括在自动驾驶领域的成功实践,也让商汤在感知、定位、轨迹规划和安全冗余等方面累积了大量真实数据与世界模型经验。

这些能力迁移到机器人等具身形态——相当于先在「会开车的大机器人」身上练兵,再扩展到泛化的移动与操作场景。

因此,商汤继「开悟」世界模型之后,发布全新「悟能」具身智能平台。一端承接日日新多模态大模型的通用能力,一端拥有打造和使用世界模型进行训练的经验,进而打造生态体系。

「开悟」世界模型背后包括商汤积累的 10 万 3D 资产,支持多视角视频生成,最多可以同时生成 11 个摄像头角度视频,并在长达 150s 的时间保持时空一致。

空间上,它可以理解遮挡、前后层级,让同一物体在不同视角下呈现一致外观。

时间上,它能够理解时序和运动规律,让物体在时间推移中保持自然连贯的变化。

并且支持参数化编辑,天气、光照、道路,以及路上的车辆,都支持一键变换。

在具身智能场景中,还可以同时处理人、物、场,构建 4D 的真实世界。

并且这种世界同时包含了第一和第三视角。

这样做的目的,是同时满足「机器人自己看到什么」与「人类示范动作长什么样」这两类信息的互补需求。

第一视角是机器人在真实运行时唯一能获取的感知流,它决定了模型推理时的输入分布;第三视角则能完整捕捉人类或机器人全身的姿态骨骼和环境关系,为动作意图、路径规划提供清晰标签。

将两种视角对齐训练,可以让模型学会把外部示范映射成自身可用的感觉动作对,一方面显著减少昂贵的遥操作数据量,另一方面提高跨机器人、跨场景的泛化能力,使同一个「大脑」既能看懂人类演示,也能在自己的相机视角下执行,从而加速具身智能落地。

基于「开悟」世界模型,商汤科技推出了「悟能」具身智能平台架构,包含感知、决策与行动等多个层次:

感知层:视觉/语音/触觉多传感输入;

决策层:LLM+世界模型协同规划;

行动层:VLA 端到端控制机械臂、移动底盘。

这一大脑,能够支持自动驾驶、机器人、机器狗等具身场景中的感知、导航、交互等功能。

在具身智能落地上,商汤选择「软硬协同」路线。目前已与众多人形机器人、物流搬运底盘厂商、家用陪伴平台等伙伴达成合作,将 T 模型预装进不同形态的机器人,让硬件天然具备多模态感知和推理能力。

未来,随着硬件越卖越多,回流的视觉、语音和操作数据也越丰富,进一步反哺模型迭代,形成正向的数据飞轮。

破解具身智能行业难题

除了发布新产品,商汤还在这次论坛上组织具身智能行业从业者以及学术界人士,一起探讨了具身世界模型发展的关键问题。

圆桌讨论首先聚焦的问题,依然是数据稀缺——一个具身智能从业者面临的共同痛点。

北京大学助理教授、智源学者、银河通用创始人兼 CTO 王鹤介绍了他的解决方案——先在虚拟环境把 pickandplace 做到几乎与现实一致,再用少量真机样本校正长尾场景。

而商汤「开悟」世界模型恰好承接了「99%」的合成任务,能够批量生成长时多摄像一致的视频。

商汤与傅利叶等伙伴合作推出的超千万数量级的机器人,则源源不断回流那关键「1%」的真实视觉、语音和操作日志,二者形成互补闭环,解决了数据从量到质的难题。

当然,数据只有「量」还远远不够,商汤联合创始人、执行董事、CTO 王晓刚认为,仅有机器人本身摄像头的第一视角并不够,上帝俯瞰的第三视角能补全肢体骨骼与全局语义;只有把两种视角对齐,端到端训练才能兼顾感知与动作。

澳大利亚科学院院士、南洋理工大学教授陶大程进一步指出,第一视角不仅要看图像,还要叠加深度、惯性、力觉等多传感器流,才能完整地捕捉「感知—意图—行动」闭环。

为此,商汤在世界模型中同步生成并标定第一和第三视角数据,确保时空一致,再映射回端侧传感器,让机器人既「看自己」也「学别人」,从而缩短仿真与现实之间的落差。

这一做法也契合圆桌嘉宾关于「视角一致性决定迁移效果」形成的共识。

关于模型路线的取舍,同样引发了热议。

上海交通大学人工智能学院副院长、上海穹彻智能科技创始人卢策吾认为,必须兼顾通用与场景闭环。

上海市信息投资股份有限公司副总裁、库帕斯科技董事长山栋明则从投资与供应链角度呼应这一观点。他认为当下只要能把设备铺出去,真实数据自然会涌回。

商汤正在验证这条「双轮」路径——多模态大模型日日新 V6.5 提供跨领域能力,垂直应用不断把真实反馈注入基座,驱动模型滚动升级。

综合来看,商汤通过世界模型的大规模仿真、合作硬件的真实数据回流、第一与第三视角的融合标注,以及「通用大脑 + 场景闭环」的协同演进,把数据、算法与硬件生态织成了一条自循环链。

商汤的数据飞轮已起步,正全速领跑未来赛道,将通过多模态与硬件协同,共筑具身智能护城河。

从工业到家庭,千万数量级机器人将承载这颗具身大脑。

来源:互联网