GPU服务器显存叠加的方法是什么?叠加后性能提升效果如何?

- 网络常识

- 2025-05-06

- 30

- 更新:2025-04-27 03:29:45

随着深度学习和高性能计算需求的不断增长,对GPU服务器的显存容量要求也越来越高。当单张显卡的显存无法满足复杂计算任务时,显存叠加技术成为了一种有效的解决方案。本文将深入探讨GPU服务器显存叠加的多种方法以及叠加后的性能提升效果,为需要处理大型数据集的科研人员和工程师提供实用指导。

显存叠加技术,也称为显存扩展技术,它允许系统将多张显卡的显存作为一个连续的内存空间来使用。这样可以有效突破单张显卡显存容量的限制,大幅提升处理大规模数据集的能力。

显存叠加方法

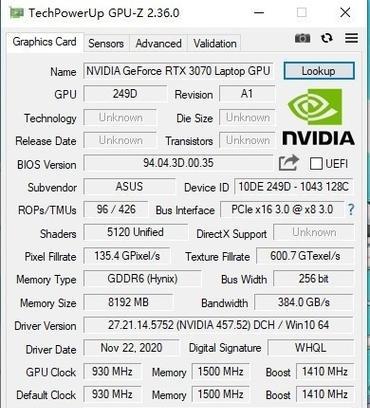

1.NVIDIANVLink技术

NVIDIANVLink是一种高速互连技术,它可以在支持的GPU之间提供比传统PCIExpress总线更高的带宽。借助NVLink,可以实现多张NVIDIAGPU的显存叠加,进而处理更大规模的数据集。

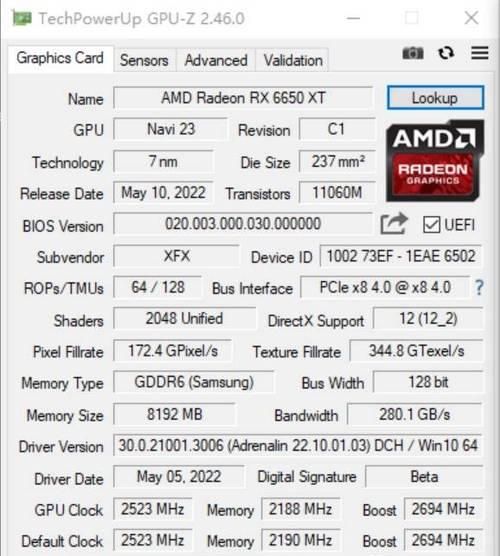

2.AMD多GPU协作技术

AMD的多GPU技术同样支持显存叠加。通过PCIExpress桥接器(如AMD的XDMA技术),可以将多个AMD显卡的显存合并在一起,提供更大容量的显存资源。

3.软件层面的显存管理

一些专业软件,如NVIDIA的GPUDirect等,能够通过软件层面的管理实现显存的叠加。这些工具通常要求显卡和主板都支持相应的技术标准。

4.分布式计算框架

利用分布式计算框架,如TensorFlow、PyTorch等,可以在软件层面上实现显存的逻辑叠加。这些框架支持跨多张GPU卡的分布式内存管理,从而能够处理超过单卡显存限制的数据。

显存叠加后的性能提升效果

显存叠加技术可以在不同程度上提升GPU服务器的性能,具体效果取决于多种因素,比如叠加技术的类型、数据处理需求的大小、以及硬件的配置等。

1.处理能力增强

显存叠加后,可以一次性加载更多的数据至显存中,从而减少数据在CPU和GPU之间的交换次数,减少I/O瓶颈,提升数据处理速度。

2.模型训练速度提升

对于深度学习模型的训练而言,显存叠加意味着可以使用更大的批量(batchsize),从而加快训练速度,缩短训练时间。

3.支持更大规模模型

显存叠加使得GPU服务器能够运行规模更大的模型,这对于科研和复杂工业应用来说非常重要。

注意事项与常见问题

在实施显存叠加技术时,需要注意以下几点:

确保所有参与显存叠加的硬件组件都支持相应技术标准。

软件层面的配置和优化是实现显存叠加功能的关键。

需要通过实践测试来评估叠加后性能的实际提升情况。

结语

通过上述介绍,我们可以看到GPU服务器显存叠加技术为处理大规模数据提供了强大的支持。它不仅能显著提升处理能力,还能够帮助运行更大规模的深度学习模型。在实际应用中,用户应根据自己的需求和硬件条件选择合适的叠加方法,并且通过细致的测试来验证其性能提升效果。如此,显存叠加技术将成为您解决大型计算任务的有力工具。