AI为何需要高性能显卡堆叠?

- 数码攻略

- 2025-05-25

- 13

- 更新:2025-05-09 19:57:20

随着人工智能(AI)技术的飞速发展,计算能力的需求也日益增长。尤其是在深度学习、图像识别、自然语言处理等领域,高性能显卡堆叠成为了解决复杂计算问题的关键。为什么AI的运行和开发需要这样的高级硬件支持?本文将详细探讨这一问题,揭示高性能显卡在AI领域中的重要性,并指导读者如何选择合适的硬件配置来满足高性能计算的需求。

高性能显卡在AI领域的应用需求

AI应用,尤其是深度学习模型的训练和推理,对计算资源的需求极大。高性能显卡,特别是GPU(图形处理单元),因其卓越的并行处理能力,成为了AI领域中处理复杂算法的优选硬件。

1.并行处理能力

GPU天生具有处理大量并行计算任务的能力。深度学习模型往往包含数百万甚至数十亿参数,需要进行大量矩阵运算。这些运算能够被GPU高效地分解为数千个小任务并同时进行计算,显著减少了模型训练的时间。

2.优化过的AI计算框架

除了硬件本身的优势,GPU还与专门为AI计算优化的软件框架紧密配合。NVIDIA的CUDA编程模型和cuDNN库为深度学习算法提供了底层支持,使得在GPU上进行AI计算变得更为高效。

3.硬件加速的重要性

在AI计算中,硬件加速能够大幅度提升计算效率。对于图像处理、视频分析等数据密集型任务,高性能显卡可以快速处理并输出结果,这对于实时应用尤为重要。

如何选择适合AI的高性能显卡堆叠

选择合适的显卡堆叠方案对于满足AI项目的特定需求至关重要。以下是几个关键因素,以帮助您做出明智的选择。

1.理解AI项目需求

要明确您的AI项目需求。是否需要处理大规模数据集?实时处理是否关键?这些问题的答案将帮助您确定所需的显卡性能。

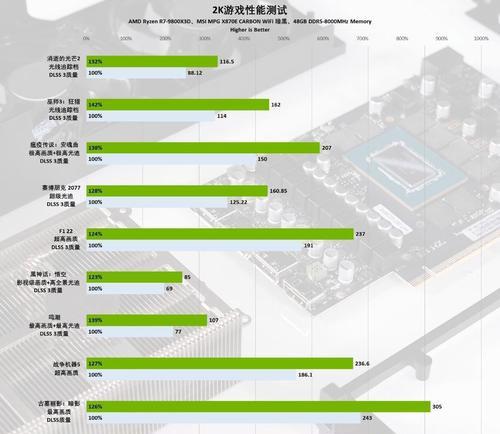

2.比较不同厂商和型号

市场上有多家厂商生产高性能显卡,例如NVIDIA、AMD等。不同型号的显卡在性能、价格以及功耗方面都有所不同。在做出选择时,需要根据AI应用的特定需求进行权衡比较。

3.考虑显卡的互连技术

在使用多块显卡进行堆叠时,显卡间的互连技术变得至关重要。NVLink、PCIExpress等技术可以提供更高的带宽和更低的延迟,有利于多GPU系统中数据的高速传输。

高性能显卡堆叠的实战配置指导

了解了硬件选择的基本原则后,以下是一些实战中的配置指导,帮助您充分利用显卡堆叠的优势。

1.选择合适的服务器平台

对于AI应用而言,服务器的选择至关重要。需要选择支持多显卡的服务器,确保散热、电源和扩展性满足高性能运算的需求。

2.软件环境的搭建

除了硬件配置,搭建一个良好的软件环境同样重要。这包括安装最新的驱动程序、CUDA工具包以及AI框架,如TensorFlow或PyTorch。

3.优化和监控

在硬件和软件准备就绪后,如何确保系统运行在最佳状态?学习如何监控系统性能和资源使用情况,以及如何进行优化,将有助于提高计算效率和稳定性。

结论

AI领域的高性能显卡堆叠是必要的,因为这直接关系到AI计算的效率和实时性。随着AI技术的不断进步,未来的计算需求只会更高。选择合适的高性能显卡堆叠方案,对任何想要在AI领域保持竞争力的组织或个人来说,都是至关重要的一步。

通过本文,您应该已经理解了高性能显卡在AI领域的重要性,并获得了一些挑选和配置显卡堆叠的实际指导。对于希望深入探索AI技术的您,这将是一段宝贵的旅程的起点。希望本文能够为您在AI硬件选择的道路上提供实质性的帮助。